Các mô hình AI tạo sinh như ChatGPT đã và đang trở thành công cụ đắc lực trong công việc hàng ngày khi chúng có thể tạo ra văn bản nghe có vẻ thuyết phục và phù hợp.

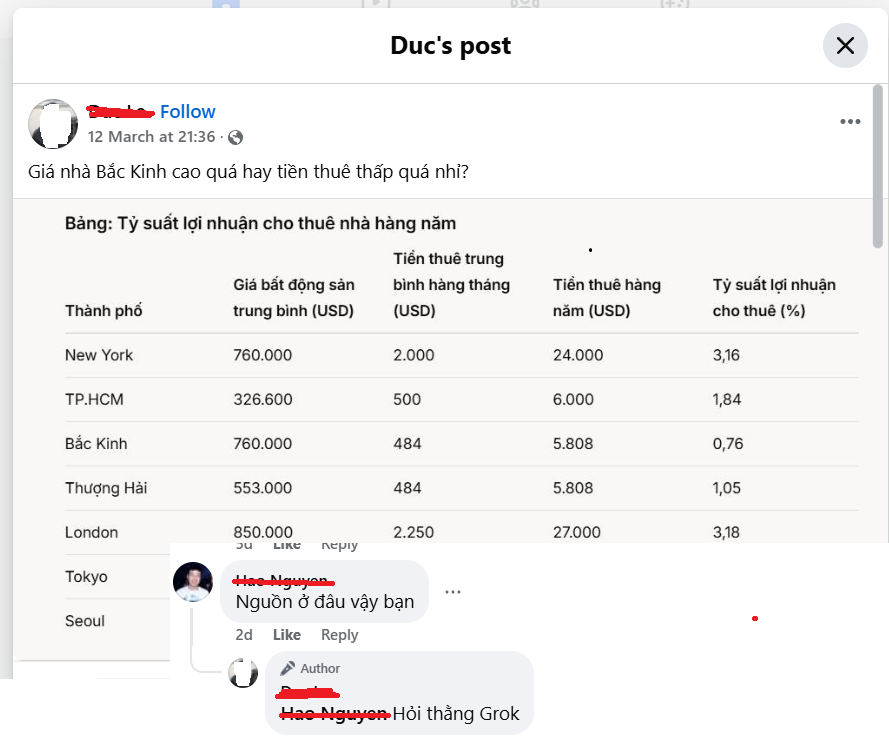

Nhưng có một thực tế đáng lo ngại đang diễn ra — nhiều người vẫn tin mọi thứ mà AI này nói với họ mà không nghi ngờ gì. Thực tế là chúng thường xuyên mắc chứng “ảo giác” (hallucination) – tự tin nêu ra những điều nghe có vẻ chính xác nhưng thực tế lại không hoàn toàn chính xác hoặc thậm chí hoàn toàn bịa đặt.

Rất nhiều người chia sẻ với bạn bè hoặc sử dụng các thông tin bịa đặt này cho các quyết định quan trọng mà không kiểm tra xem nó có thực sự đúng hay không. Sự tin tưởng này rất rủi ro, đặc biệt là khi các công cụ này ngày càng nghe có vẻ thuyết phục hơn cho dù chúng đúng hay sai.

Học cách phát hiện những ảo giác này là điều vô cùng cần thiết trong xã hội hiện nay. Trong bài viết này mình chia sẻ một số cách đơn giản (không cần dựa vào công cụ) để biết khi nào AI đang bịa ra sự việc:

1. Cẩn thận với sự tự tin thái quá

AI thường đưa ra thông tin không chính xác với cùng sự tự tin như-sự-thật. Nếu một phản hồi của AI mang tính khẳng định chắc chắn một cách bất thường về các chi tiết mơ hồ, hãy xem xét kỹ và kiểm tra lại ở nơi khác. Ví dụ, nếu bạn hỏi “Thủ đô của Úc là gì?” và AI tự tin nói rằng “Thủ đô của Úc là Sydney” (thực ra là Canberra) và không kèm thêm bất cứ chú thích, diễn giải, disclaimer nào khác, thì điều đó bạn nên cảnh giác cao với những câu trả lời như vậy.

2. Chú ý đến lỗ hổng trong tư duy phản biện

Hãy chú ý đến những mâu thuẫn logic trong các phản hồi. Hãy suy nghĩ nghiêm túc về việc liệu những gì bạn đang đọc có thực sự hợp lý hay không.

Quá trình suy luận của LLM cũng giống như con người chúng ta, và cũng thường rơi vào những cái bẫy ngụy biện phổ biến như:

- Chỉ dẫn lại lời người khác vì nghe có vẻ uy tín (authority bias)

- Chỉ chú ý đến thông tin xác nhận lại những gì chúng ta đã có niềm tin ban đầu (confirmation bias)

- Bằng chứng bị thiếu mà không rõ ràng ngay lập tức (survivor bias)

Hãy dành chút thời gian tìm hiểu về các lỗi ngụy biện thể giúp phát hiện ra những vấn đề này.

Ví dụ, nếu bạn đã tin rằng xe điện thân thiện với môi trường và AI tuyên bố “Xe điện không gây hại cho môi trường”, bạn nên đặt câu hỏi về câu trả lời quá đơn giản này (sản xuất pin và phát điện vẫn có tác động đến môi trường).

3. Mức độ chi tiết cụ thể của thông tin

Nhìn chung câu trả lời mang tính chung chung và khái quát thì thường an toàn hơn và ít có khả năng chứa lỗi. Khi bạn thấy thông tin rất chi tiết — đặc biệt là các số liệu, ngày tháng hoặc tên cụ thể — thì đó là dấu hiệu để bạn hoài nghi và kiểm tra thực tế.

Nếu AI nói với bạn rằng “Tài sản người giàu nhất Việt Nam là 123 tỷ USD”, thì chuông báo động ảo giác cần được vang lên trong đầu bạn.

4. Xem xét chủ đề

AI có nhiều khả năng bị ảo giác khi thảo luận về các chủ đề mang tính chuyên ngành. Với ít mẫu đáng tin cậy hơn từ dữ liệu đào tạo để suy luận, AI tự động “điền vào chỗ trống” bằng thông tin nghe có vẻ hợp lý nhưng không chính xác.

Hãy nhớ rằng: Về mặt cấu tạo, mọi LLM được thiết kế để tạo ra các phản hồi nghe-có-vẻ-hay, không nhất thiết phải là những phản hồi đúng về mặt thực tế (factually correct).

Điều này khiến các chủ đề phức tạp hoặc chuyên ngành đặc biệt dễ bị lỗi. Ví dụ, nếu AI tự tin tuyên bố “Hình phạt tối đa cho hành vi chạy quá tốc độ ở Việt Nam là 10 năm tù”, bạn chắc chắn nên xác minh điều này với các nguồn pháp lý chính thức.

5. Hỏi AI lấy thông tin từ đâu

Một số AI có khả năng trích dẫn nguồn khi trả lời, một số khác thì không, nhưng thực tế thì đa số chúng không thể thực sự trích dẫn nguồn một cách chính xác và cụ thể.

Tuy vậy việc yêu cầu chúng cung cấp thông tin dẫn chứng có thể tiết lộ thêm các chi tiết có thể dẫn đến việc làm rõ nguyên nhân sai phạm. Mặc dù AI có thể “bịa ra” các tài liệu tham khảo, nhưng việc đối chiếu lại này này thường làm nổi bật sự không nhất quán hoặc nhắc nhở AI đánh dấu sự không chắc chắn của chính nó.

Nếu bạn hỏi “Nguồn cho số liệu thống kê về biến đổi khí hậu đó là gì?” và nhận được tên một nghiên cứu được bịa ra (không thể tìm thấy trên mạng) để trả lời, thì bạn đã phát hiện ra một ảo giác.

6. Thử các cách tiếp cận khác nhau

Đặt cùng một câu hỏi theo những cách khác nhau hoặc đặt ra các câu hỏi tiếp theo có liên quan. Để có kết quả tốt nhất, hãy thử điều này trong các phiên chat khác nhau, hoặc với các mô hình AI khác nhau hoàn toàn.

AI có xu hướng bám sát một “mạch truyện” của mình trong một cuộc hội thoại với người dùng, ngay cả khi thông tin chứa đựng trong đó là đó sai. Hãy bắt đầu lại hoặc yêu cầu AI không tham khảo các câu trả lời trước đó một cách rõ ràng có thể giúp phát hiện ra sự không nhất quán.

Ví dụ, trước tiên hãy hỏi “Đội nào đã vô địch World Cup năm 2018?” Sau đó, trong một phiên khác, hãy hỏi “Đội tuyển bóng đá quốc gia của quốc gia châu Âu nào đã giành chức vô địch FIFA tại Nga năm 2018?” Nếu bạn nhận được các câu trả lời khác nhau, có nghĩa là có điều gì đó không ổn.

7. Xác minh lại thông tin quan trọng

Luôn kiểm tra chéo thông tin quan trọng với các nguồn bên ngoài đáng tin cậy như trang web của chính phủ, tạp chí học thuật hoặc các hãng tin uy tín.

Ngay cả khi AI thực hiện tìm kiếm trên web, nó cũng không thể thực sự đánh giá được độ tin cậy của nguồn. Hãy đặc biệt thận trọng với thông tin có thể đến từ các trang web ít uy tín hơn hoặc thậm chí là nội dung khác do AI tạo ra.

Nếu AI tuyên bố vitamin C chữa cảm lạnh thông thường, hãy kiểm tra các trang web y tế có uy tín trước khi tin vào điều đó.

8. Áp dụng trực giác của riêng bạn

Trước khi hỏi AI bất cứ điều gì, hãy tự hỏi mình xem câu hỏi của bạn:

- Liệu câu hỏi này có thể được trả lời một cách chính xác chỉ bằng cách đọc tài liệu? Có những kiến thức mang tính thực nghiệm và không được ghi nhận bởi sách vở

- Liệu các tài liệu có thể chứa đựng các thông tin cần thiết để trả lời có phải là loại tài liệu sẵn có trên mạng? Có rất nhiều thông tin trên mạng là những thông tin hiếm có (VD dữ liệu kinh doanh nhạy cảm), hoặc phải trả tiền bản quyền để truy cập (VD các bản báo cáo phân tích của công ty nghiên cứu thị trường).

Đối với các dạng kiến thức này, sự thiếu đi tính lặp đi lặp lại hoặc xuất hiện thường xuyên trong tập dữ liệu đào tạo của AI sẽ khiến cho khả năng ảo giác tăng lên nhiều lần.

Mặt khác, dù có vẻ bề ngoài như một chuyên gia, phản hồi của AI giống như một học sinh lớp tiểu học lặp lại những gì chúng nhìn thấy trong một cuốn sách giáo khoa nâng cao — đó không phải là sự am hiểu, thấu hiểu kiến thức chuyên môn thực sự.

Đối với những câu hỏi đòi hỏi sự phán đoán hoặc hiểu biết chuyên ngành, AI có lẽ không phải là lựa chọn tốt nhất của bạn.