Trong bối cảnh Việt Nam bắt đầu chú trọng việc bảo vệ dữ liệu riêng tư trong một vài năm trở lại đây, đặc biệt là với sự ra đời của Nghị định 13/2023/NĐ-CP về bảo vệ dữ liệu cá nhân, thì việc sử dụng, nghiên cứu về differential privacy (DP) lại chưa được thịnh hành trong các xuất bản phẩm bằng tiếng Việt. Đây có lẽ là một điểm khuyết khá lớn trong việc kiến tạo nền móng khoa học cho việc bảo vệ dữ liệu cá nhân, cả từ góc độ pháp lý đến góc độ áp dụng thực tiễn trong công việc.

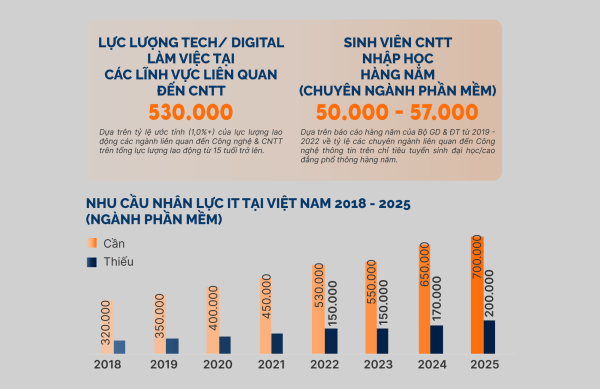

Đặc biệt, với sự thịnh hành của các mô hình trí tuệ nhân tạo (AI) dựa trên nền tảng học sâu, làm biến đổi một cách căn bản dữ liệu huấn luyện đầu vào, việc đáp ứng yêu cầu tuân thủ việc bảo vệ dữ liệu cá nhân là cực kỳ phức tạp về mặt thực tế trong công việc của các nhà phát triển trong việc quản lý, đào tạo, sử dụng các mô hình AI. Các nghiên cứu bảo vệ dữ liệu cá nhân tại Việt Nam hiện tại mới chỉ dừng lại ở mức độ đề cập chung về các rủi ro nhưng chưa đào sâu nghiên cứu về các giải pháp ngăn ngừa, khắc phục về mặt kỹ thuật,[1] do đó cơ sở khoa học để đề ra những quy định pháp luật cũng như tiêu chuẩn kỹ thuật cho phù hợp với tình hình thực tiễn áp dụng là còn khá yếu.

Nhằm khắc phục vấn đề này, tác giả dành riêng một phần của nghiên cứu để phân tích về định nghĩa, cách hiểu của DP, là một trong những nền tảng trụ cột trong các cơ chế thực thi quyền riêng tư dưới góc độ kỹ thuật,[2] với mong muốn giúp những người nghiên cứu chính sách pháp luật hiểu rõ hơn về DP bằng những ngôn ngữ không mang nặng tính toán học.

Trong phần tiếp theo, tác giả sẽ phân tích về việc ứng dụng DP trong các mô hình học sâu, là nền tảng của các công nghệ AI mới nhất hiện nay (mô hình ngôn ngữ lớn – LLM).

Sau cùng, tác giả sẽ làm rõ sự liên quan của cơ chế bảo vệ quyền riêng tư theo Nghị định 13/2023/NĐ-CP và các cơ chế thực thi một các khả thi đối với việc nghiên cứu, phát triển các mô hình trí tuệ nhân tạo tại Việt Nam để có thể đảm bảo quyền riêng tư. Đây sẽ là cơ sở khoa học cho việc đặt ra các chế định pháp luật phù hợp để bảo vệ quyền riêng tư trong bối cảnh mới.

I. Giới thiệu tổng quan về differential privacy

Differential privacy là một thuật ngữ không mới trong giới nghiên cứu về dữ liệu trên thế giới, nhằm tạo ra một cơ chế bảo vệ tính riêng tư của một điểm dữ liệu (trong trường hợp cụ thể này có thể hiểu là thông tin của một cá nhân), mà không làm ảnh hưởng đến đặc tính phân phối về mặt thống kê của tập dữ liệu lớn.

1. Định nghĩa về differential privacy

1.1. Định nghĩa về mặt toán học

Cynthia Dwork, học giả tiên phong trong phát triển diffrential privacy hiện đại,[3] đã đưa ra định nghĩa về mặt toán học cho DP như sau :

Một hàm ngẫu nhiên K sẽ cho ra giá trị ε-differential privacy, nếu với tập dữ liệu D1 và D2 khác nhau nhiều nhất một phần tử, và cho mọi tập con S trong phạm vi hàm K đảm bảo được:

![]()

Diễn giải: (Xác suất của hàm K trên tập D1 là tập con của S) nhỏ hơn hoặc bằng tích của ![]() với (Xác suất của hàm K trên tập D2 là tập con của S).[i]

với (Xác suất của hàm K trên tập D2 là tập con của S).[i]

Khi giá trị ε càng nhỏ thì ![]() tiến gần về 1 (đối với ε nhỏ thì

tiến gần về 1 (đối với ε nhỏ thì ![]() ), nghĩa là xác suất của hàm K trên tập D1 và tập D2 là gần như nhau, đảm bảo rằng các thuộc tính thống kê là gần như nhau, qua đó bảo đảm đối với 2 tập dữ liệu đầu vào khác nhau một phần tử không có sự khác biệt về mặt tính chất thống kê. Nói cách khác, việc thêm vào hay bớt đi một phần tử không làm ảnh hưởng đến tính chất chung của dữ liệu đầu ra. Ý nghĩa của điều này sẽ được giải thích cụ thể hơn ở mục I.3.

), nghĩa là xác suất của hàm K trên tập D1 và tập D2 là gần như nhau, đảm bảo rằng các thuộc tính thống kê là gần như nhau, qua đó bảo đảm đối với 2 tập dữ liệu đầu vào khác nhau một phần tử không có sự khác biệt về mặt tính chất thống kê. Nói cách khác, việc thêm vào hay bớt đi một phần tử không làm ảnh hưởng đến tính chất chung của dữ liệu đầu ra. Ý nghĩa của điều này sẽ được giải thích cụ thể hơn ở mục I.3.

1.2. Định nghĩa differential privacy về mặt ứng dụng

Từ định nghĩa về mặt toán học của Dwork, nhóm tác giả Wood đã giải thích:[4]

Differential privacy là một định nghĩa toán học về quyền riêng tư, đặt trong bối cảnh phân tích thống kê và máy học. Nó cho phép thu thập, phân tích và chia sẻ các dữ liệu thống kê (như trung bình, bảng tương quan, dữ liệu tổng hợp[5]) về các dữ liệu cá nhân mà vẫn đảm bảo quyền riêng tư của mỗi cá nhân trong dữ liệu.

Để làm rõ hơn vấn đề này, cũng cần nhận thức rõ DP là một loại cơ chế/thuật toán/kỹ thuật phân tích cho phép đảm bảo quyền riêng tư, chứ không phải là một thuật toán cụ thể nào. Về mặt thực tiễn áp dụng, có nhiều loại thuật toán DP như ngẫu nhiên hóa câu trả lời, sử dụng cơ chế Laplace để thêm nhiễu, sử dụng vector thưa (sparse)…[6] Hiện nay, nhiều nhà phát triển như Google, Tensorflow, Pytorch đã cung cấp mã nguồn mở bộ thư viện DP của mình để các nhà phát triển có thể tự do sử dụng.[7]

Nhóm tác giả Wood khẳng định, trên khía cạnh ứng dụng trong công việc, quyền riêng tư là một thuộc tính của việc phân tích dữ liệu chứ không phải là kết quả của hoạt động phân tích. Điều này có ý nghĩa rất lớn trong việc đặt ra các quy định pháp luật: việc áp dụng DP trong công việc sẽ làm giảm rủi ro vi phạm quyền riêng tư khi phân tích, sử dụng dữ liệu, chứ không phải là sẽ tạo ra kết quả là một bộ dữ liệu/kết quả đảm bảo quyền riêng tư.

Nói cách khác, với cách hiểu này thì việc ứng dụng DP không giúp cho các nhà phát triển tạo ra sản phẩm hoàn toàn tuân thủ quyền riêng tư, mà chỉ là một giải pháp giúp làm giảm rủi ro xâm phạm quyền riêng tư trong quá trình phát triển, sử dụng.

2. Bàn về vấn đề thuật ngữ differential privacy

Yêu cầu chuyển ngữ không đặt ra bắt buộc đối với nhiều thuật ngữ sử dụng trong ngành khoa học dữ liệu nói chung, học máy nói riêng, mà các nhà phát triển thường sử dụng trực tiếp thuật ngữ tiếng Anh. Tuy nhiên, đối với thuật ngữ differential privacy, nó có gắn liền với yếu tố “quyền riêng tư”, là một khía cạnh mang tính pháp lý-kỹ thuật, sẽ là đề tài nghiên cứu của không ít công trình khoa học đặt trong bối cảnh Việt Nam đang đẩy mạnh phát triển mạnh về không gian mạng và trí tuệ nhân tạo.[8] Do đó, việc chuyển ngữ đối với thuật ngữ này là điều cần thiết để giúp ngành khoa học pháp lý Việt Nam có cái nhìn tốt hơn về khả năng điều chỉnh thực tế của quy phạm pháp luật lên hoạt động xã hội trong lĩnh vực công nghệ thông tin.

Khi dịch từ tiếng Anh sang tiếng Việt, cụm từ differential có thể mang nhiều ý nghĩa. Như đã phân tích ở mục trên, trong thuật ngữ differential privacy, thì từ “differential” đề cập đến mức độ nhạy cảm của cơ chế quyền riêng tư đối với những thay đổi trong dữ liệu đầu vào. Cụ thể, nó đo lường sự khác biệt về dữ liệu đầu ra của thuật toán ngẫu nhiên khi áp dụng cho hai bộ dữ liệu chỉ khác nhau một phần tử.

Về mặt ngôn ngữ, differential (danh từ) để chỉ sự khác biệt giữa 2 thứ khi được so sánh, hoặc (tính từ) mang tính khác biệt, không bằng nhau.[9]

Về mặt toán học, differential trong differential calculus là phép tính vi phân (tiếng Hán 微分 – wéifēn, trong đó vi (分) là nhỏ, và phân (微) là danh từ chỉ phần, điểm, hoặc động từ chia, tách), từ đó cho người ta biết được tốc độ của sự thay đổi của hàm số khi biến số thay đổi.

Về mặt xác suất thống kê, differential trong stochastic differential equation (SDE) là phương trình vi phân ngẫu nhiên, nghiên cứu về tác động của những thay đổi nhỏ (thêm vào/bớt đi một điểm dữ liệu) lên sự phân phối.

Không đào quá sâu về mặt chuyển ngữ, nhưng ta có thể nhận thấy cụm từ differential trong tiếng Anh thường gắn liền với từ vi (tiếng Hán 分) trong tiếng Việt để chỉ tính chất nhỏ: vi phân (toán học), vi sai (máy móc). Tuy nhiên, khi chuyển ngữ differential privacy sang tiếng Việt, theo tác giả thì nên sử dụng 2 cách:

– Quyền riêng tư khác biệt: nhấn mạnh sự khác nhau giữa 2 tập kết quả đầu ra, qua đó đo lường mức độ đảm bảo sự riêng tư.

– Quyền riêng tư tách biệt: nhấn mạnh sự tách biệt của một điểm dữ liệu so với kết quả đầu ra của một hàm số (nói cách khác, sự ảnh hưởng của sự thay đổi một điểm dữ liệu cho kết quả đầu ra của một hàm số).

Cũng có một số tài liệu khác dùng cách chuyển ngữ là quyền riêng tư vi phân.[10] Như đã phân tích về mặt ngữ nghĩa, thuật ngữ Hán Việt này có thể dùng chung để chỉ cho cả 2 cách hiểu ở trên. Tuy nhiên, cách dùng này cũng có phần hạn chế khi nó có thể gây hiểu lầm về bản chất của biện pháp đảm bảo quyền riêng tư là sử dụng phép toán vi phân (trong khi đó thực ra phép toán vi phân dùng để đo lường mức độ riêng tư được đảm bảo bởi thuật toán).

3. Ý nghĩa đằng sau sự “khác biệt” trong thuật ngữ differential privacy

3.1. Ý nghĩa về mặt lý thuyết

Với sự “khác biệt” được tạo nên khi áp dụng cơ chế DP trong việc phân tích dữ liệu, đào tạo AI, sản phẩm tạo ra đảm bảo được các đặc tính sau:

– Tính không thể phân biệt: Đặc tính này cho biết sự hiện diện hay vắng mặt của dữ liệu của bất kỳ cá nhân nào trong tập dữ liệu sẽ không ảnh hưởng đáng kể đến kết quả đầu ra của thuật toán. Nếu D1 bao gồm dữ liệu của một cá nhân cụ thể còn D2 thì không, thì một cơ chế riêng tư khác biệt đảm bảo rằng người quan sát không thể dễ dàng phân biệt tập dữ liệu nào đã được sử dụng nếu chỉ dựa trên kết quả đầu ra. Thuộc tính này đảm bảo rằng quyền riêng tư của cá nhân được bảo vệ.

– Đảm bảo quyền riêng tư: Bằng cách giới hạn sự khác biệt về xác suất đầu ra ở mức tối đa ![]() , quyền riêng tư khác biệt đảm bảo rằng nguy cơ tái nhận dạng hoặc rò rỉ dữ liệu của một cá nhân được giảm thiểu. Giá trị ε càng nhỏ thì mức độ đảm bảo quyền riêng tư càng cao.

, quyền riêng tư khác biệt đảm bảo rằng nguy cơ tái nhận dạng hoặc rò rỉ dữ liệu của một cá nhân được giảm thiểu. Giá trị ε càng nhỏ thì mức độ đảm bảo quyền riêng tư càng cao.

3.2. Ý nghĩa về mặt thực tế trong công việc có liên quan đến xử lý dữ liệu

– Tổng hợp, sử dụng dữ liệu nhân tạo (synthetic data): Khi tổng hợp dữ liệu mới cho mục đích đào tạo hoặc phân tích, với giá trị ![]() bị ràng buộc cụ thể, nhà phát triển có thể đảm bảo rằng dữ liệu tổng hợp có thể được tính toán và chia sẻ với rủi ro tối thiểu ảnh hưởng đến quyền riêng tư cá nhân.

bị ràng buộc cụ thể, nhà phát triển có thể đảm bảo rằng dữ liệu tổng hợp có thể được tính toán và chia sẻ với rủi ro tối thiểu ảnh hưởng đến quyền riêng tư cá nhân.

Ví dụ như một công ty bảo hiểm y tế có thể sử dụng tập dữ liệu về thông tin sức khỏe để xác định tỷ lệ bảo hiểm. Vì tập dữ liệu bao gồm thông tin sức khỏe của nhiều cá nhân, ứng dụng DP đảm bảo rằng việc bao gồm hoặc loại trừ dữ liệu của một cá nhân không ảnh hưởng đáng kể đến kết quả phân tích. Bằng cách này, quyền riêng tư của một cá nhân đơn lẻ được bảo vệ và công ty vẫn có thể đưa ra quyết định hợp lý dựa trên dữ liệu tổng hợp.

– Giá trị ε có thể được sử dụng là một mốc lường sự đánh đổi giữa quyền riêng tư và mức độ tiện ích: Giá trị ε nhỏ hơn mang lại quyền riêng tư mạnh mẽ hơn nhưng có thể làm giảm tiện dụng hoặc độ chính xác của dữ liệu đầu ra, trong khi giá trị ε lớn hơn sẽ tăng tiện ích nhưng làm suy yếu mức độ riêng tư.

Điều này có ý nghĩa giúp nhà quản trị, nhà lập pháp có một cơ sở mang tính định lượng để đưa ra quy định phù hợp, thay vì chỉ đưa quy định mang tính định tính.

– Độ nhạy cảm của dữ liệu nhóm: việc áp dụng cơ chế DP này mở rộng đến các nhóm cá nhân. Nếu một nhóm người tham gia c lo ngại về dữ liệu chung của họ, cơ chế DP đảm bảo rằng độ pha loãng (dilation) của xác suất bị giới hạn bởi ![]() . Điều này có nghĩa là khi quy mô c của nhóm tăng lên thì mức độ đảm bảo quyền riêng tư sẽ yếu đi, nhưng đối với các nhóm nhỏ thì vấn đề này có thể nằm trong giới hạn chấp nhận được. Điều này có ý nghĩa trong việc điều chỉnh dữ liệu của một nhóm người trong cùng một lúc, thay vì điều chỉnh từng lần nhỏ, vốn sẽ gây phát sinh chi phí tốn kém hơn.

. Điều này có nghĩa là khi quy mô c của nhóm tăng lên thì mức độ đảm bảo quyền riêng tư sẽ yếu đi, nhưng đối với các nhóm nhỏ thì vấn đề này có thể nằm trong giới hạn chấp nhận được. Điều này có ý nghĩa trong việc điều chỉnh dữ liệu của một nhóm người trong cùng một lúc, thay vì điều chỉnh từng lần nhỏ, vốn sẽ gây phát sinh chi phí tốn kém hơn.

Tuy nhiên điều này chỉ đúng với giá trị ε nhỏ. Trong một cuộc khảo sát thực hiện năm 2019,[11] giá trị ε được đặt ra tại các đơn vị được khảo sát mang tính chất biến thiên rất lớn, từ 0.1 đến 4, và cũng được đặt ra giới hạn ε cũng được thực hiện một cách rất vô chừng, không có căn cứ xác định hiệu quả cụ thể.

Dĩ nhiên, như cũng được đề cập trong khảo sát, việc đặt ra một giá trị ε cụ thể có tính chất áp dụng chung là điều gần như bất khả thi. Tuy nhiên, Dwork cho rằng chúng ta có thể lập nên một cơ sở dữ liệu The Epsilon Registry lưu trữ chung về giá trị ε để các nhà phát triển có cơ sở tham khảo, đánh giá mức độ bảo đảm riêng tư cho sản phẩm của mình. Đến thời điểm 6/2024, đề xuất này vẫn chưa được hiện thực hóa.

3.3. Ý nghĩa về pháp lý

Hiểu được quyền riêng tư khác biệt là điều quan trọng đối với các chuyên gia pháp lý vì nó liên quan trực tiếp đến quyền riêng tư và luật bảo vệ dữ liệu. Bằng cách đảm bảo rằng các kỹ thuật phân tích dữ liệu tuân thủ quyền riêng tư khác biệt, các tổ chức có thể bảo vệ quyền riêng tư của cá nhân tốt hơn và tuân thủ các tiêu chuẩn pháp lý như Quy định bảo vệ dữ liệu chung (GDPR) của châu Âu và các luật về quyền riêng tư khác.

Mặt khác, quyền riêng tư ở đây được hiểu như một cơ chế opt-out cho phép người dùng hạn chế/không cung cấp dữ liệu của mình vào trong việc sử dụng/đào tạo AI mà không làm ảnh hưởng đáng kể đến kết quả đào tạo.

Điều này mang ý nghĩa thực tiễn rất lớn trong khoa học pháp lý, bởi lẽ dữ liệu hàng ngày vẫn được thu thập một cách tự động, chủ động bởi các đơn vị kiểm soát dữ liệu thông qua cơ chế pháp lý đồng thuận (consent), trong đó chủ thể dữ liệu có rất ít lựa chọn trong việc ngăn ngữa thông tin bị sử dụng một cách bị động, mà chỉ có thể chủ động yêu cầu gỡ bỏ hoặc không sử dụng. Áp dụng cơ chế DP là một bước đệm quan trọng và là một cơ chế trung gian giúp chủ thể dữ liệu có thể kiểm soát được dữ liệu của cá nhân được sử dụng một cách hợp lý, không để lộ các thông tin riêng tư đến các cá nhân, tổ chức khác.

Tuy nhiên, với những vướng mắc thực tế trong việc áp dụng DP như ở mục trên thì các nhà lập pháp cần đặt ra bài toán cân nhắc xem liệu có nên quy định áp dụng bắt buộc sử dụng DP trong quá trình phát triển, nếu có thì giá trị ε (và cả δ, đối với các mô hình học sâu) cần được xác định như thế nào.

II. Quyền riêng tư khác biệt trong học sâu

Học sâu (deep learning) là một phương pháp/thuật toán cho phép máy tính tạo ra kết quả đầu ra thông qua việc học hỏi để kiến tạo nên bộ trọng số (weight) làm nền tảng cho việc tính toán đầu ra, thay vì một phép tính toán (bao gồm cả truy xuất dữ liệu) trực tiếp.[12] Học sâu là nền tảng cho các ứng dụng AI hiện nay như nhận diện hình ảnh, xử lý ngôn ngữ tự nhiên. Các mô hình ngôn ngữ lớn (LLM), dạng sản phẩm AI đang phát triển mạnh mẽ hiện nay, cũng là một dạng thức nâng cao của học sâu.

Với tính chất 2 bước của việc học sâu, từ giai đoạn học hỏi đến bước tính toán đầu ra; dữ liệu đầu vào ban đầu của mô hình học sâu đã được mã hóa, chuyển đổi một cách căn bản, toàn diện thành các thông số trong bộ trọng số, chứ không còn được lưu trữ, thể hiện dưới dạng dữ liệu con người có thể hiểu được.

Sự phát triển của các mô hình ngôn ngữ đang đặt ra yêu cầu hết sức cấp thiết về việc nâng cao quyền riêng tư, bởi lẽ tập dữ liệu huấn luyện của các mô hình này là cực kỳ đa dạng về nội dung, phạm vi. Khác với các mô hình học sâu truyền thống, mô hình ngôn ngữ có các bước phát triển mang tính nhảy vọt, trong đó nó có thể mã hóa thông tin cá nhân cụ thể thành các trọng số con người không thể hiểu được, nhưng lại có thể vẫn xuất bản ra kết quả ngược lại thành ngôn ngữ tự nhiên mà con người hiểu được, thông qua các truy vấn bằng ngôn ngữ tự nhiên.

Chính vì vậy, nếu thông tin của một cá nhân A được chứa đựng trong bộ dữ liệu huấn luyện của hệ thống AI học sâu, hệ thống này có thể cho ra lại toàn bộ thông tin của A trong kết quả đầu ra với một xác suất P luôn lớn hơn 0. Sau khi đã học hỏi và tạo nên bộ trọng số, việc xóa dữ liệu của A ra khỏi bộ trọng số là vô cùng khó khăn, nên sẽ tồn tại nguy cơ làm rò rỉ (tái định danh – reidentification) dữ liệu của A.[13]

Quyền riêng tư khác biệt lúc này sẽ đóng vai trò đánh giá mức độ rủi ro tái định danh dữ liệu của A và cân nhắc đâu là mức chấp nhận được về mặt thực tiễn. Tuy nhiên trước khi nghiên cứu của nhóm tác giả Martín Abadi được công bố năm 2016,[14] việc áp dụng DP và tính toán mức độ rủi ro ε đối với các mô hình học sâu được xem là gần như bất khả thi về mặt kỹ thuật. Chỉ sau khi nghiên cứu này được xuất bản, việc áp dụng DP mới dần trở nên hiện thực hóa với việc giảm chi phí tính toán cũng như giảm thiểu mức độ hao tổn chính xác của mô hình. Tuy vậy, các thuật toán tối ưu hóa (để mô hình có thể hội tụ) có tích hợp DP vẫn tốn rất nhiều thời gian so với không DP. Cụ thể, DP-SGD vẫn tốn nhiều gấp 4-5 lần thời gian để huấn luyện so với SGD truyền thống trên tập thử nghiệm CIFAR.[15] Thậm chí, trên tập dữ liệu thử nghiệm khác là IMDB, thời gian huấn luyện giữa DP và không-DP chênh lệch tới hơn 1600 lần,[16] mặc dù khi sử dụng kỹ thuật JL Projections thì độ chênh lệch này giảm còn từ 3-30 lần tùy vào mức độ tối ưu hóa về độ chính xác. Khi sử dụng thuật toán DP-SGD cùng với kỹ thuật gradient clippling trên tập MNIST và CIFAR, mô hình hội tụ chậm hơn khoảng 1.5-2.5 lần,[17] hoặc nhanh hơn “một cách đáng kể” đối với kỹ thuật adaptive learning rate ADADP.[18]

Qua một số ví dụ kể trên có thể thấy, mặc dù các kỹ thuật áp dụng DP để đảm bảo quyền riêng tư trên các mô hình học sâu đã có những bước phát triển đáng kể, nhưng thời gian huấn luyện mô hình cũng như sự hao hụt độ chính xác ở mức độ thực nghiệm là vẫn còn một khoảng cách khá xa vời so với yêu cầu thực tế kinh doanh (hãy tưởng tượng kể cả trong trường hợp tốt nhất ở trên, chi phí/thời gian đào tạo tăng gấp 1.5-2.5 lần trong môi trường kinh doanh thực tế, sẽ đẩy chi phí hoạt động cho doanh nghiệp lên như thế nào).

Bên cạnh đó, DP còn có một nhược điểm lớn trong bối cảnh hiện nay là không thể ứng dụng vào việc tinh chỉnh các các mô hình nền tảng (foundation model) lại cho các mục đích sử dụng cụ thể.[19] Mô hình nền tảng là các mô hình đã được đào tạo cơ bản trên một tập dữ liệu lớn, và các nhà phát triển có thể tinh chỉnh cho mô hình xuất ra được kết quả theo đúng thể thức, nội dung mà nhà phát triển mong muốn. Các mô hình nền tảng như GPT-3 chính là cơ sở để xây dựng nên ChatGPT, công cụ được biết đến rộng rãi ngày nay. Việc điều chỉnh các ứng dụng đầu cuối giống như ChatGPT cho đảm bảo tính riêng tư cần được thực hiện qua các biện pháp khác, phổ biến là thông qua học theo ngữ cảnh (in-context) learning, học hỏi tăng cường với phản hồi từ con người – RLHF.[20]

III. Ứng dụng quyền riêng tư khác biệt để bảo vệ dữ liệu cá nhân tại Việt Nam

Mặc dù tồn tại những hạn chế như đã phân tích tại mục trên, DP vẫn có những giá trị nhất định trong việc bảo vệ dữ liệu cá nhân tại Việt Nam. Cụ thể, theo quy định tại khoản 5 Điều 9 Nghị định 13/2023/NĐ-CP, chủ thể của dữ liệu có quyền yêu cầu bên xử lý dữ liệu xóa dữ liệu.

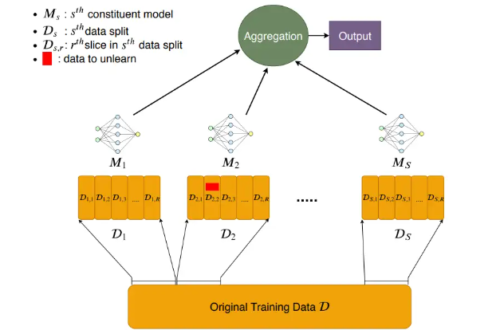

Yêu cầu này xuất phát từ một quyền cơ bản được định nghĩa trong GDPR là quyền được lãng quên (RBTF), được thể chế hóa từ những năm 2014, khi mà máy học hiện đại vẫn chưa lên ngôi và phát triển như hiện nay. Việc xóa tuyệt đối điểm dữ liệu cụ thể (unlearning) trong bộ trọng số của học sâu, tính đến thời điểm hiện tại 2024, là vẫn gần như không thể về mặt lý thuyết, do sự hiểu biết hạn chế đối với mạng thần kinh nhân tạo.[21] Dĩ nhiên, các nhà nghiên cứu đã đưa ra được rất nhiều giải pháp thay thế cho việc bỏ học một cách thực nghiệm, nghĩa là sau khi áp dụng thì dữ liệu có thể xem như là đã được xóa, mặc dù bằng chứng cho việc đó thì có thể không rõ ràng chính xác ở mức tuyệt đối.

Trong số các giải pháp được đề bởi học giả Liu, thì chỉ có các giải pháp DP là khả dĩ nhất khi ứng dụng với các mô hình học sâu bởi tính chất mã nguồn mở, có khả năng ứng dụng phổ quát ngoài mô hình ngôn ngữ lớn (như đối với các mô hình nhận diện hình ảnh trong y khoa với tập dữ liệu nhạy cảm của bệnh nhân, hay nhận diện khuôn mặt, nhận diện rủi ro tài chính…)

Tương tự như vậy, chủ thể của dữ liệu có quyền phản đối xử lý dữ liệu (tại khoản 8 Điều 9 Nghị định 13/2023/NĐ-CP). Điều này về mặt thực tiễn có thể được thực hiện qua cơ chế opt-out bằng DP, và trong trường hợp này DP hoàn toàn có thể sử dụng làm bằng chứng chứng minh rằng dữ liệu của một người dùng cụ thể không làm tác động đến kết quả đầu ra của toàn bộ dữ liệu chung. Khi này, về mặt pháp lý, nhà lập pháp có thể cân nhắc liệu có thể xem như là đã đáp ứng yêu cầu phản đối xử lý dữ liệu hay chưa.

Về mặt lý thuyết, nhà phát triển có thể đáp ứng hoàn toàn yêu cầu xóa bỏ hoặc phản đối xử lý dữ liệu bằng việc xóa hoàn toàn dữ liệu của cá nhân ra khỏi bộ dữ liệu huấn luyện, trước khi huấn luyện một mô hình AI. Tuy nhiên, về mặt thực tiễn, điều này là cực kỳ tốn kém về mặt chi phí, thời gian. Việc chấp nhận xóa về mặt thực nghiệm bằng cơ chế DP là một giải pháp cho phép nhà phát triển tuân thủ pháp luật mà vẫn đảm bảo hiệu quả kinh tế, và là cơ sở pháp lý để giải quyết tranh chấp nếu có.

IV. Kết luận

Quyền riêng tư khác biệt chỉ là một trong số rất nhiều các biện pháp kỹ thuật khả thi để giúp nhà phát triển có thể bảo vệ tính riêng tư của dữ liệu được nghiên cứu, sử dụng trong đào tạo AI.[22] Nó là một công cụ mạnh mẽ giúp cân bằng nhu cầu phân tích dữ liệu với yêu cầu bắt buộc phải bảo vệ quyền riêng tư cá nhân.

Đối với các chuyên gia pháp lý, việc hiểu khái niệm này là rất quan trọng để tư vấn về quyền riêng tư và đảm bảo tuân thủ luật bảo vệ dữ liệu. Dĩ nhiên, DP cũng có rất nhiều hạn chế trong việc áp dụng. Tuy nhiên, khi sử dụng phương pháp tiếp cận để đưa ra được những giải pháp kỹ thuật mang tính định tính, những quy định kể cả về pháp lý cũng như tiêu chuẩn kỹ thuật về bảo vệ dữ liệu cá nhân sẽ mang tính khả thi cao hơn, giúp tạo ra một thế giới kỹ thuật số riêng tư và an toàn hơn.

Nghiên cứu này được đặt ra trong bối cảnh cần có những rào cản pháp lý-kỹ thuật được đặt ra cho việc đảm bảo quyền riêng tư cho người dùng, theo đó các nhà nghiên cứu pháp lý có thể hiểu rõ hơn về tính khả thi của các biện pháp mang tính kỹ thuật và ứng dụng thực tế trong việc bảo vệ quyền riêng tư.

Bài viết được chia sẻ trong buổi Hội thảo “Bảo vệ dữ liệu cá nhân trong môi trường số – Nghiên cứu so sánh pháp luật Việt Nam và Thái Lan” do Khoa Luật Quốc tế Trường Đại học Luật TP.HCM tổ chức ngày 03/7/2024.

Danh mục Tài liệu đã dẫn

I. Văn bản Quy phạm pháp luật

- Quyết định số 127/QĐ-TTg ngày 26-01-2021 của Thủ tướng Chính phủ: Ban hành Chiến lược quốc gia về nghiên cứu, phát triển và ứng dụng Trí tuệ nhân tạo đến năm 2030,

- Quyết định 699/QĐ-BTTTT ngày 03/05/2024 của Bộ Thông tin Truyền thông phê duyệt Kế hoạch hành động năm 2024 triển khai Chiến lược phát triển ứng dụng Trí tuệ nhân tạo đến năm 2030 (Chiến lược AI ứng dụng)

- Nghị định 13/2023/NĐ-CP của Chính phủ ban hành ngày 17/04/2023 về bảo vệ dữ liệu cá nhân

II. Tài liệu tiếng Việt

- Cục Công nghệ thông tin – Bộ Tư pháp (2024) “Sự giao thoa giữa an ninh mạng và trí tuệ nhân tạo” truy cập tại https://dx.moj.gov.vn/su-giao-thoa-giua-an-ninh-mang-va-tri-tue-nhan-tao-296.htm-296.htm;

- Trường Đại học Luật TP.HCM (2022) Hội thảo Quốc tế: “Trách nhiệm pháp lý trong ứng dụng trí tuệ nhân tạo: Thực tiễn quốc tế và kinh nghiệm cho Việt Nam” truy cập tại https://www.hcmulaw.edu.vn/vi/hoat-dong-khoa-hoc-hop-tac-quoc-te/tong-thuat-hoi-thao-quoc-te-trach-nhiem-phap-ly-trong-ung-dung-tri-tue-nhan-tao-thuc-tien-quoc-te-va-kinh-nghiem-cho-viet-nam

- Hà Lê Hoài Trung, Đặng Trần Khánh (2022) “Những rủi ro và các phòng chống vi phạm Tính riêng tư trong mô hình học cộng tác”, Tạp chí Khoa học Công nghệ và Thực phẩm 22 (3) 344-358 tr 351.

- Trần Quốc Thái, Nguyễn Thị Kim Thanh (2023) ‘Mô hình nền tảng’ qua lăng kính pháp luật Việt Nam về quyền tác giả”, Tạp chí Kinh tế Sài Gòn, truy cập tại https://thesaigontimes.vn/mo-hinh-nen-tang-qua-lang-kinh-phap-luat-viet-nam-ve-quyen-tac-gia/

- Trần Trương Tuấn Phát , Đặng Trần Khánh (2022) “Rủi ro vi phạm riêng tư dữ liệu trong học sâu”, Tạp chí Khoa học Công nghệ và Thực phẩm 22 (3) (2022) 330-343;

- Hà Lê Hoài Trung , Đặng Trần Khánh (2022) “Những rủi ro và các phòng chống vi phạm tính riêng tư trong mô hình học cộng tác”, Tạp chí Khoa học Công nghệ và Thực phẩm 22 (3) (2022) 344-358

- Nguyễn Thị Hồng Hà (2023) “Học sâu và ứng dụng phương pháp học sâu có đảm bảo tính riêng tư?”, Tạp chí An toàn thông tin truy cập tại https://m.antoanthongtin.gov.vn/gp-atm/hoc-sau-va-ung-dung-phuong-phap-hoc-sau-co-dam-bao-tinh-rieng-tu-109590

III. Tài liệu tiếng nước ngoài

- Ken Liu (2024) “Machine Unlearning in 2024”, Standford, truy cập tại https://ai.stanford.edu/~kzliu/blog/unlearning

- Wood, Alexandra, et al. “Differential privacy: A primer for a non-technical audience.” Vand. J. Ent. & Tech. L. 21 (2018): 209

- Cynthia Dwork, Aaron Roth (2014) The Algorithmic Foundations of Differential Privacy

- Dwork, Cynthia, Nitin Kohli, và Deirdre Mulligan (2019) “Differential privacy in practice: Expose your epsilons!.” Journal of Privacy and Confidentiality 9.2

- Narayanan, Arvind, and Vitaly Shmatikov (2006) “How to break anonymity of the netflix prize dataset.” arXiv preprint cs/0610105.

- Abadi, Martin, et al (2016) “Deep learning with differential privacy”, Proceedings of the 2016 ACM SIGSAC conference on computer and communications security.

- Bu, Z., Gopi, S., Kulkarni, J., Lee, Y. T., Shen, H., & Tantipongpipat, U. (2021). Fast and memory efficient differentially private-sgd via JL projections. Advances in Neural Information Processing Systems, 34, 19680-19691.

- Fang, Huang, et al. (2022) “Improved convergence of differential private sgd with gradient clipping”, The Eleventh International Conference on Learning Representations

- Xu, Z., Shi, S., Liu, A. X., Zhao, J., & Chen, L. (2020). An adaptive and fast convergent approach to differentially private deep learning. In IEEE INFOCOM 2020-IEEE Conference on Computer Communications (pp. 1867-1876)

[1] Cục Công nghệ thông tin – Bộ Tư pháp (2024) “Sự giao thoa giữa an ninh mạng và trí tuệ nhân tạo” truy cập tại https://dx.moj.gov.vn/su-giao-thoa-giua-an-ninh-mang-va-tri-tue-nhan-tao-296.htm-296.htm; Trường Đại học Luật TP.HCM (2022) Hội thảo Quốc tế: “Trách nhiệm pháp lý trong ứng dụng trí tuệ nhân tạo: Thực tiễn quốc tế và kinh nghiệm cho Việt Nam” truy cập tại https://www.hcmulaw.edu.vn/vi/hoat-dong-khoa-hoc-hop-tac-quoc-te/tong-thuat-hoi-thao-quoc-te-trach-nhiem-phap-ly-trong-ung-dung-tri-tue-nhan-tao-thuc-tien-quoc-te-va-kinh-nghiem-cho-viet-nam

[2] Ken Liu (2024) “Machine Unlearning in 2024”, Standford, truy cập tại https://ai.stanford.edu/~kzliu/blog/unlearning

[3] Theo tác giả Dwork thì nền móng của differential privacy đã được dặt ra từ năm 1977 với nghiên cứu của T. Dalenius (1977) Towards a methodology for statistical disclosure control, Statistik Tidskrift 15, pp. 429–222.

[4] Wood, Alexandra, et al. “Differential privacy: A primer for a non-technical audience.” Vand. J. Ent. & Tech. L. 21 (2018): 209

[5] Dữ liệu tổng hợp (synthetic data) ở đây không nên hiểu là dữ liệu được tạo ra từ các phép tính tổng hợp số liệu đơn giản như cộng trừ nhân chia, mà cần được hiểu dữ liệu được tạo ra một cách nhân tạo (để phân biệt với các dữ liệu thu thập từ thực tế) nhưng vẫn chứa đựng các thuộc tính thống kê gần giống với dữ liệu thực. Cách hiểu này có ý nghĩa vô cùng quan trọng trong việc đào tạo học máy với các dữ liệu nhạy cảm (tránh làm lộ thông tin thực tế), các dữ liệu khó thu thập trên thực tế mà vẫn đảm bảo kết quả chính xác.

[6] Cynthia Dwork, Aaron Roth (2014) The Algorithmic Foundations of Differential Privacy

[7] Dưới license Apache 2.0. Xem https://github.com/google/differential-privacy, https://github.com/tensorflow/privacy, https://github.com/pytorch/opacus

[8] Tiêu biểu như Quyết định số 127/QĐ-TTg ngày 26-01-2021 của Thủ tướng Chính phủ: Ban hành Chiến lược quốc gia về nghiên cứu, phát triển và ứng dụng Trí tuệ nhân tạo đến năm 2030, hướng dẫn bởi Quyết định 699/QĐ-BTTTT ngày 03/05/2024 của Bộ Thông tin Truyền thông.

[9] Từ điển Cambridge https://dictionary.cambridge.org/dictionary/english/differential

[10] Hà Lê Hoài Trung, Đặng Trần Khánh (2022) “Những rủi ro và các phòng chống vi phạm Tính riêng tư trong mô hình học cộng tác”, Tạp chí Khoa học Công nghệ và Thực phẩm 22 (3) 344-358 tr 351.

[11] Dwork, Cynthia, Nitin Kohli, và Deirdre Mulligan. “Differential privacy in practice: Expose your epsilons!.” Journal of Privacy and Confidentiality 9.2 (2019), trang 11.

[12] Nguyễn Thị Hồng Hà (2023) “Học sâu và ứng dụng phương pháp học sâu có đảm bảo tính riêng tư?”, Tạp chí An toàn thông tin truy cập tại https://m.antoanthongtin.gov.vn/gp-atm/hoc-sau-va-ung-dung-phuong-phap-hoc-sau-co-dam-bao-tinh-rieng-tu-109590

[13] Xem ví dụ về thuật toán tấn công tái định danh bộ dữ liệu của Netflix, Narayanan, Arvind, and Vitaly Shmatikov (2006) “How to break anonymity of the netflix prize dataset.” arXiv preprint cs/0610105.

[14] Abadi, Martin, et al (2016) “Deep learning with differential privacy”, Proceedings of the 2016 ACM SIGSAC conference on computer and communications security.

[15] Abadi Martin (2016) trang 9.

[16] Bu, Z., Gopi, S., Kulkarni, J., Lee, Y. T., Shen, H., & Tantipongpipat, U. (2021). Fast and memory efficient differentially private-sgd via JL projections. Advances in Neural Information Processing Systems, 34, 19680-19691.

[17] Fang, Huang, et al. (2022) “Improved convergence of differential private sgd with gradient clipping”, The Eleventh International Conference on Learning Representations trang 9

[18] Xu, Z., Shi, S., Liu, A. X., Zhao, J., & Chen, L. (2020). An adaptive and fast convergent approach to differentially private deep learning. In IEEE INFOCOM 2020-IEEE Conference on Computer Communications (pp. 1867-1876). IEEE, biểu đồ số 1, trang 1871

[19] Trần Quốc Thái, Nguyễn Thị Kim Thanh (2023) ‘Mô hình nền tảng’ qua lăng kính pháp luật Việt Nam về quyền tác giả”, Tạp chí Kinh tế Sài Gòn, truy cập tại https://thesaigontimes.vn/mo-hinh-nen-tang-qua-lang-kinh-phap-luat-viet-nam-ve-quyen-tac-gia/

[20] Ken Liu (2024) tlđd.

[21] Xem Ken Liu (2024), tlđd.

[22] Xem thêm Trần Trương Tuấn Phát , Đặng Trần Khánh (2022) “Rủi ro vi phạm riêng tư dữ liệu trong học sâu”, Tạp chí Khoa học Công nghệ và Thực phẩm 22 (3) (2022) 330-343; Hà Lê Hoài Trung , Đặng Trần Khánh (2022) “Những rủi ro và các phòng chống vi phạm tính riêng tư trong mô hình học cộng tác”, Tạp chí Khoa học Công nghệ và Thực phẩm 22 (3) (2022) 344-358

[i] Chú giải dành cho độc giả chưa nắm các khái niệm về mặt xác suất thống kê trong học máy:

Hàm ngẫu nhiên K: là một thuật toán, hay một cơ chế nhận vào một tập dữ liệu và cho ra một kết quả. Vì nó là hàm ngẫu nhiên, kết quả đầu ra sẽ chứa đựng một sự ngẫu nhiên nhất định, nên với cùng một tập dữ liệu đầu vào có thể cho ra nhiều kết quả khác nhau trong nhiều lần thực thi phép tính khác nhau

Tập dữ liệu D1 và D2: Là hai tập dữ liệu khác nhau nhiều nhất một thành phần. Sự khác nhau này có thể là do sự thêm vào, bớt đi hoặc thay đổi một điểm dữ liệu

Tập hợp con S: đại diện cho tất cả các kết quả đầu ra có thể đưa ra bởi hàm ngẫu nhiên K.

Xác suất P: Là xác suất mà hàm K đưa mà một kết quả thuộc tập S khi nhận dữ liệu đầu vào nào đó, ở đây là D1 và D2