Đây là bài viết của Ken Liu, xuất bản bởi Standford về những cập nhật mới nhất về machine learning tính đến thời điểm tháng 5/2024. Nội dung này đã được dịch và hiệu đính bởi mình.

Khi các mô hình máy học (machine learning – ML) của chúng ta ngày nay trở nên lớn hơn và các tập huấn luyện (trước) của chúng phát triển đến các quy mô khó hiểu, mọi người ngày càng quan tâm[1] đến khái niệm lãng quên máy học (machine unlearning) để xóa những thứ không mong muốn như dữ liệu riêng tư, kiến thức cũ, tài liệu có bản quyền, nội dung độc hại/không an toàn, khả năng nguy hiểm và thông tin sai lệch mà không cần đào tạo lại mô hình từ đầu.

Nói một cách khái quát, việc lãng quên máy là việc loại bỏ các ảnh hưởng của dữ liệu huấn luyện ra khỏi mô hình đã huấn luyện. Mục tiêu của hoạt động làm cho một mô hình mục tiêu quên đi (unlearn) là việc tìm cách tạo ra một mô hình được làm cho quên (unlearned model) tương đương với—hoặc ít nhất là “hoạt động giống” với —một mô hình được đào tạo lại (retrained model) được đào tạo trên cùng một bộ dữ liệu của mô hình mục tiêu, nhưng trừ đi thông tin cần được xóa bỏ đào tạo.

Để đạt được điều này, cần phải giải quyết rất nhiều câu hỏi. Làm thế nào để chúng ta mô tả thông tin cần được quên đi? Chúng ta có thể có được mô hình được đào tạo lại gốc (để làm nền tảng so sánh) hay không? Nếu không, làm thế nào để chúng ta thực sự đánh giá được việc quên đi điều đó? Thậm chí, liệu chúng ta có đủ khả năng để xác minh và kiểm tra việc quên đi không? Liệu việc giả vờ như đã quên (như cách con người vẫn thường làm) có được xem là thỏa mãn hay không? Liệu việc buộc quên đi thậm chí có phải là giải pháp phù hợp không? Nếu là phù hợp, thì là phù hợp cho các vấn đề gì?

Các định nghĩa chính xác về việc làm quên đi, các kỹ thuật, sự đảm bảo và các thước đo/đánh giá sẽ phụ thuộc vào:

- Tác vụ của mô hình ML (ví dụ: phân loại nhị phân hoặc mô hình hóa ngôn ngữ);

- Dữ liệu cần loại bỏ (ví dụ: một tập hợp hình ảnh, bài báo hoặc kiến thức về chế tạo bom napalm);

- Thuật toán loại bỏ (ví dụ: tinh chỉnh tương đối (heuristic fine-tuning)/xóa các thành phần mô hình);

- Mục tiêu của việc loại bỏ (ví dụ: vì quyền riêng tư của người dùng, hoặc loại bỏ nội dung độc hại).

Trong bài viết này, tác giả mong muốn giới thiệu một cách đơn giản, khái quát cho khán giả về việc lãng quên máy học và đề cập đến một số vấn đề như bảo vệ bản quyền,[2] vụ kiện giữa New York Times và OpenAI,[3] quyền được lãng quên trong GDPR,[4] thử thách NeurIPS loại bỏ khả năng học của máy,[5] hệ thống AI dựa trên truy xuất – RAG,[6] sự an toàn của AI,[7] cùng với một số suy nghĩ của tác giả về lĩnh vực này. Mặc dù việc loại bỏ là chủ đề rộng có thể áp dụng cho hầu hết các mô hình ML, nhưng bài viết này sẽ tập trung nhiều vào các mô hình nền tảng.[8]

1. Sơ lược về lịch sử và các động lực cho việc lãng quên máy học

Vấn đề về việc lãng quên máy học đã được đề cập từ khá sớm.[9] Các hoạt động khám phá nghiên cứu ban đầu chủ yếu được thúc đẩy bởi Điều 17 của GDPR, thường được gọi là “quyền được lãng quên” (RTBF ) kể từ năm 2014.[10] RTBF về cơ bản cho biết người dùng có quyền yêu cầu xóa dữ liệu của họ từ một nhà cung cấp dịch vụ (ví dụ như xóa tài khoản Gmail của bạn).

RTBF được đặt ra với dụng ý rất rõ ràng, và cũng rất dễ hiêu cầu thực hiện khi dữ liệu của người dùng được lưu trữ một cách có cấu trúc, giống như cách Google xóa một loạt liên kết khỏi chỉ mục của mình để phản hồi các yêu cầu RTBF.[11]

Tuy nhiên, RTBF lại không thực sự được đề xuất đề điều chỉnh vấn đề học máy. Vào thời điểm năm 2014, các nhà hoạch định chính sách đã không thể ngờ rằng học sâu (deep learning) sẽ là một khối hỗn hợp khổng lồ giữa dữ liệu và điện toán,[12] mà việc phân tách và diễn giải khối hỗn hợp này hóa ra lại cực kỳ khó khăn. Sự khó của việc xóa dữ liệu khỏi các mô hình ML sau đó đã thúc đẩy nghiên cứu về cái mà sau này được gọi là “ xóa dữ liệu”[13] và “lãng quên máy học”.[14]

Một thập kỷ sau, vào năm 2024, quyền riêng tư của người dùng không còn là động lực duy nhất cho việc lãng quên máy học. Chúng ta đã chuyển từ huấn luyện các mạng tích chập (CNN) nhỏ trên dữ liệu hình ảnh khuôn mặt, sang đào tạo các mô hình ngôn ngữ khổng lồ, mà trong đó dữ liệu huấn luyện bao gồm cả các nội dung có trả phí, có bản quyền,[15] thậm chí cả nội dung độc hại, nguy hiểm.[16] Rõ ràng chúng ta muốn “xóa” các nội dung này ra khỏi mô hình ML— mặc dù đôi khi chúng chỉ chứa đựng một vài nội dung không mong muốn. Bản chất của các mô hình được huấn luyện gần đây cũng đã thay đổi một cách căn bản. Thay vì sử dụng nhiều mô hình chuyên biệt nhỏ (trong đó mỗi mô hình thực hiện tốt một nhiệm vụ), chúng ta bắt đầu xây dựng và sử dụng một mô hình khổng lồ duy nhất có thể thực hiện rất nhiều tác vụ.[17]

Tác giả cho rằng, hiện tại động lực để lãng quên máy học thuộc hai nhóm:

- Thu hồi quyền truy cập (hãy nghĩ về việc loại bỏ dữ liệu riêng tư/dữ liệu có bản quyền).

Trong một thế giới lý tưởng, dữ liệu nên được coi là “được mượn” (có thể là được phép hoặc không được phép) và do đó có thể được “trả lại”, và việc làm lãng quên sẽ cho phép việc thu hồi như vậy.

Việc lãng quên máy học là một thách thức khi nhìn từ quan điểm này. Một khó khăn chính ở đây là với sự hiểu biết hạn chế của chúng ta về học sâu, dữ liệu được đào tạo thành một mô hình giống như “vật tư tiêu hao” (không thể “trả lại” sau khi sử dụng). Dữ liệu cũng có thể là loại độc nhất không thể thay thế được (ví dụ: lịch sử trò chuyện của bạn)[18] và thậm chí có thể được coi là thành quả lao động[19] với những lợi ích tài chính cũng như lợi ích từ việc kiểm soát. Một thách thức khác trongviệc thu hồi quyền truy cập là việc yêu cầu bằng chứng về việc đã lãng quên; như và như sẽ được đề cập ở phần sau, điều này không phải lúc nào cũng có thể thực hiện được.

Những khó khăn này cho thấy rằng có lẽ cũng nên sửa đổi các luật như RTBF và suy nghĩ về các giải pháp thay thế như tạo ra thị trường dữ liệu , nơi chủ sở hữu dữ liệu được đền bù thỏa đáng để họ không muốn yêu cầu hủy học ngay từ đầu. Để minh họa, giả sử Bob ăn bánh của Alice (dữ liệu), Alice thà Bob trả tiền cho cô ấy hoặc trả lại thứ gì đó tương đương (tiền bồi thường) hơn là Bob nôn về trạng thái trước khi ăn (làm cho lãng quên.

Trong thực tiễn, một cách để thực hiện việc thu hồi quyền truy cập là thông qua một số hình thức đào tạo lại mô hình cơ sở một cách định kỳ. Nhiều nhà cung cấp mô hình đã thực hiện việc này để giữ cho mô hình của họ luôn cạnh tranh và cập nhật đầy đủ. Ví dụ: OpenAI có thể thu thập một loạt yêu cầu loại bỏ và đáp ứng hàng loạt chúng trong quá trình đào tạo lại hàng năm (hoặc, được hướng dẫn bởi khoảng thời gian được xem là “trì hoãn quá mức ” của RTBF mà yêu cầu phải được đáp ứng).[20] Nói rộng hơn, điều này gợi ý các giải pháp mang tính kỹ thuật-xã hội cho việc loại bỏ kiến thức: các nhà lập pháp có thể bắt buộc đào tạo lại định kỳ như vậy và đặt ra các thời hạn khả thi về mặt kinh tế, để giảm bớt chi phí cho chủ sở hữu mô hình.

- Chỉnh sửa & đính chính mô hình (khi cần điều chỉnh tính độc hại, sai lệch, loại bỏ kiến thức cũ/nguy hiểm). Nghĩa là, mô hình đã được đào tạo về điều gì đó không mong muốn và chúng ta muốn khắc phục nó. Điều này liên quan chặt chẽ đến các bài nghiên cứu khoa học về chỉnh sửa mô hình.[21] Gần đây, thuật ngữ “lãng quên điều chỉnh” (corrective machine unlearning)[22] đã được đề xuất để điều chỉnh tác động của các dữ liệu xấu lên mô hình. Từ góc độ này, việc loại bỏ kiến thức cũng có thể được xem như một cơ chế giảm thiểu rủi ro sau đào tạo đối với những lo ngại về an toàn AI (được thảo luận thêm trong Phần 4).

Không giống như việc thu hồi quyền truy cập, chúng ta có thể khoan dung hơn với việc chỉnh sửa mô hình, vì việc chỉnh sửa xuất phát từ mong muốn hơn là sự cần thiết do pháp luật quy định, như mong muốn về độ chính xác của mô hình đối với phân loại hình ảnh hoặc tính độc hại của văn bản được tạo (dĩ nhiên, những sai lệch này vẫn có nguy cơ gây ra tác hại thực sự). Ở đây, chúng ta không nhất thiết cần những đảm bảo một cách hợp thức để việc lãng quên những kiến thức là hữu ích trên thực tế; chúng ta có rất nhiều ví dụ trong đó mọi người đã triển khai các mô hình được cho là “đủ an toàn”. Bài benchmark gần đây WMDP, đánh giá một mô hình về kiến thức nguy hiểm,[23] là một ví dụ điển hình về việc đánh giá bằng thực nghiệm hiệu quả của việc lãng quên.

2. Các hình thức lãng quên máy học

Việc unlearning sẽ được xem là quá tầm thường nếu chúng ta chỉ đơn giản là huấn luyện lại mô hình với bộ dữ liệu không chứa đựng những thứ mong muốn xóa. Chúng ta cần một thứ gì đó tốt hơn vì (1) việc đào tạo lại có thể tốn kém và (2) có thể tốn rất nhiều công sức chỉ để tìm ra nội dung cần xóa khỏi dữ liệu đào tạo — hãy nghĩ đến việc tìm tất cả các dẫn chiếu về Harry Potter trong hàng nghìn tỷ token. Về cơ bản, các kỹ thuật làm lãng quên được thiết kế nhằm mục đích giảm thiểu hoặc tránh chi phí đào tạo lại này trong khi vẫn tạo ra các kết quả giống hệt hoặc tương tự.

Các nghiên cứu về việc làm lãng quên có thể được phân loại đại khái thành các loại sau:

- Lãng quên một cách chính xác (exact unlearning)

- Lãng quên thông qua quyền riêng tư tách biệt (differential privacy)[24]

- Loại bỏ theo kinh nghiệm, trong đó dữ liệu cần loại bỏ được biết chính xác (các ví dụ đào tạo)

- Loại bỏ theo kinh nghiệm, trong đó dữ liệu cần được loại bỏ không được xác định rõ ràng (khi đề cập đến kiến thức nói chung)

- Chỉ cần yêu cầu bỏ học?

Các phương pháp lãng quên không chính xác (từ 2-4), đôi khi còn được gọi là lãng quên xấp xỉ (approximate unlearning),[i] là khi mô hình được làm cho quên hoạt động xấp xỉ giống như một mô hình đã được huấn luyện lại. Hình thức thứ 5 thì khá mới mẻ và thú vị, nhưng áp dụng chủ yếu cho các mô hình instruction-following.

Trong phần dưới đây, chúng ta sẽ xem xét đại khái từng loại này trông như thế nào, cùng với những gì tác giả nghĩ là hứa hẹn, những cảnh báo và những câu hỏi cần đặt ra trong tương lai.

2.1. Lãng quên một cách chính xác (exact unlearning)

Việc loại bỏ chính xác đại khái yêu cầu rằng mô hình được làm cho quên và mô hình được đào tạo lại phải giống hệt nhau về mặt thống kê phân phối; nghĩa là chúng có thể giống hệt nhau trong điều kiện ngẫu nhiên cố định.

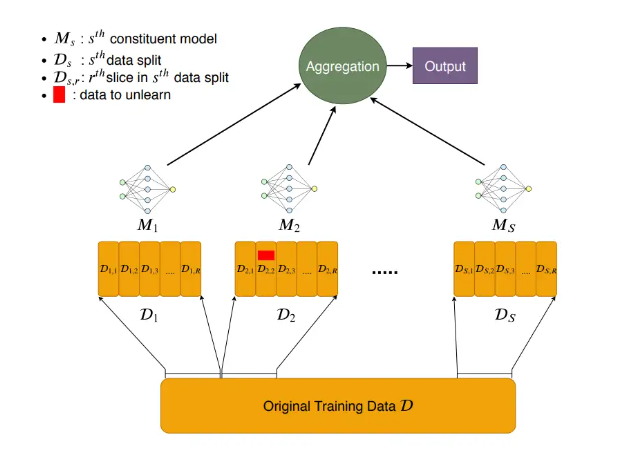

Các kỹ thuật để loại bỏ chính xác được đặc trưng bởi công trình đầu tiên của Cao & Yang và SISA.[25] Trong SISA, một sơ đồ rất đơn giản, tập huấn luyện được chia thành N ???? tập con không chồng chéo và một mô hình riêng biệt được huấn luyện cho mỗi tập con. Việc loại bỏ liên quan đến việc đào tạo lại mô hình tương ứng và không có các điểm dữ liệu cần được loại bỏ. Điều này giúp giảm chi phí từ việc đào tạo lại vani xuống 1/ N 1/ ???? (rẻ hơn nếu chúng ta giữ các điểm kiểm tra mô hình). Suy luận sau đó liên quan đến việc tập hợp mô hình.

Hình 2. Minh họa SISA: chỉ huấn luyện các mô hình trên các phân đoạn dữ liệu

Một cách tổng quát hơn, bản chất của việc loại bỏ chính xác dạng này là chúng ta muốn các thành phần mô-đun trong thuật toán máy học sẽ phản ứng ra các tập dữ liệu huấn luyện khác (có khả năng được tách biệt với các mô đun khác).

Có một số lợi ích của việc loại bỏ chính xác:

- Thuật toán chính là bằng chứng. Thiết kế của SISA cho chúng ta biết rằng dữ liệu cần lãng quên sẽ không bao giờ đóng góp cho các thành phần khác. Thực ra mà nói, việc chứng minh một cách chính thức việc mô hình đã loại bỏ điều gì đó là khá khó khăn.[26]

- Nó biến vấn đề làm lãng quên được thành vấn đề về độ chính xác/hiệu quả. Điều này làm cho việc lãng quên chính xác trở nên dễ tiếp cận hơn do sự phức tạp trong việc đánh giá việc unlearn và thiếu các bài benchmark.

- Có khả năng giải thích theo thiết kế. Bằng cách cung cấp cấu trúc cho việc học, chúng ta cũng hiểu rõ hơn về cách các điểm dữ liệu nhất định đóng góp vào hiệu suất.

Hạn chế chính là khá hiển nhiên: định luật về mở rộng (scaling law)[27] các mô hình lớn chống lại việc phân chia mô hình và dữ liệu một cách thái quá như được thực hiện trong SISA. Mà có thật như vậy không? Tác giả nghĩ sẽ rất thú vị khi xem lại sharding trong bối cảnh của các mô hình lớn, dựa trên các nghiên cứu gần đây về việc sáp nhập các mô hình,[28] gợi ý tính khả thi của việc hợp nhất không gian của các trọng số (weight-space) giữa các mô hình lớn. Như sẽ tìm hiểu trong các phần tiếp theo, sự lộn xộn của việc loại bỏ gần đúng và việc đánh giá nó, đặc biệt là trong bối cảnh của các mô hình lớn, khiến cho việc loại bỏ chính xác trở nên rất hấp dẫn.

2.2. Lãng quên thông qua quyền riêng tư tách biệt

Kiểu công việc này đại khái nói rằng: nếu mô hình hoạt động ít nhiều giống nhau khi có hoặc không có bất kỳ điểm dữ liệu cụ thể nào, thì chúng ta không cần phải loại bỏ điều gì khỏi điểm dữ liệu đó. Nói một cách khái quát hơn, chúng ta đang yêu cầu sự gần gũi về phân phối giữa các mô hình được làm cho quên và mô hình được đào tạo lại.

Đối với những độc giả chưa quen với quyền riêng tư tách biệt (differential privacy – DP) trong học máy, DP xác định sự đảm bảo về tính không thể phân biệt có thể định lượng giữa hai mô hình M và M’ được đào tạo trên các tập dữ liệu X , X’ khác nhau trong bất kỳ ví dụ huấn luyện nào. Quy trình chuẩn, DP-SGD,[29] hoạt động bằng cách cắt bớt L2-norm của các gradient trên mỗi ví dụ và đưa một số nhiễu Gaussian trên mỗi tọa độ vào các gradient. Ý tưởng ở đây là nhiễu sẽ che giấu hoặc che khuất sự đóng góp của bất kỳ gradient đơn nào, sao cho mô hình cuối cùng sẽ không nhạy cảm với bất kỳ ví dụ nào. Nó thường được ký hiệu là (ε, δ)-DP; độ nhiễu càng cao thì các scalar (ε, δ) càng nhỏ thì mô hình càng riêng tư.

Trực quan của thao tác này là nếu đối thủ không thể phân biệt (một cách đáng tin cậy) các mô hình, thì điều đó giống như điểm dữ liệu này chưa bao giờ được học – do đó không cần phải học lại. DP có thể được sử dụng để đạt được hình thức loại bỏ này, nhưng do tính chất một chiều của việc loại bỏ (trong đó chúng ta chỉ quan tâm đến việc loại bỏ dữ liệu chứ không phải bổ sung), DP là một định nghĩa chặt hơn.[30] Khái niệm về việc loại bỏ này đôi khi được gọi là (α, β)-unlearning, trong đó (α, β) đóng vai trò tương tự như (ε, δ) để đo lường mức độ gần gũi về phân phối.

Các kỹ thuật ví dụ theo hướng này bao gồm: (1) lưu trữ các checkpoint của mô hình lồi (DP)[31] và lãng quên được thực hiện khi đào tạo lại từ các checkpoint đó;[32] và (2) ngoài việc đã áp dụng các kỹ thuật trước đó, hãy thêm SISA để giúp mô hình thích ứng với các yêu cầu unlearning sau đó(tức là những yêu cầu xuất hiện sau khi mô hình đã xuất bản).

Việc lãng quên dựa trên DP tốt ở chỗ nó mang lại một số hình thức đảm bảo về mặt thống kê. Tuy nhiên, có một số cân nhắc quan trọng làm hạn chế khả năng áp dụng của nó cho các mô hình lớn :

- Nhiều kết quả dỡ bỏ như vậy chỉ áp dụng cho mô hình hoặc hoặc hàm tổn thất lồi.[33]

- Mức độ nào của việc lãng quên là đủ (giá trị của (ε ,δ)-DP hoặc (α, β)-unlearning)? Ai quyết định nó?

- Đối với các mô hình lớn, hệ thống ML hiện tại không phù hợp với khối lượng công việc trên mỗi mẫu ví dụ của các quy trình kiểu DP. Chi phí về bộ nhớ cũng sẽ rất cao.

- Hơn nữa, giống như DP, sự đảm bảo có thể bị hủy bỏ nhanh chóng bởi nhiều yêu cầu unlearning hơn (cao nhất với tốc độ O =

) với k yêu cầu, theo định lý cấu tạo nên DP).

) với k yêu cầu, theo định lý cấu tạo nên DP). - Định nghĩa DP ngầm cho rằng chúng ta quan tâm đến tất cả các điểm dữ liệu là như nhau. Nhưng một số ví dụ sẽ có khả năng nhận được yêu cầu unlearn cao hơn, và một số ví dụ khác thì lại hoàn toàn không đóng góp gì cho việc học.[34]

- Các quy trình DP cũng có thể ảnh hưởng rất nhiều đến độ chính xác của mô hình, đôi khi theo cách không công bằng.[35]

Đặc biệt, đối với các mô hình lớn, cũng cần phân biệt trường hợp lãng quên dữ liệu pre-training và lãng quên dữ liệu fine-tuning. Cái sau dễ xử lý hơn rất nhiều; ví dụ: chúng ta thực sự có thể tinh chỉnh các mô hình lớn với quyền riêng tư tách biệt nhưng không quá nhiều khi đào tạo trước.[36]

2.2.1. Giả mạo và ý nghĩa của nó đối với các định nghĩa lãng quên kiểu DP

Quy trình làm lãng quên đôi khi có thể yêu cầu kiểm tra bên ngoài, nghĩa là chúng ta muốn chứng minh rằng quy trình loại bỏ đã thực sự xảy ra.

Ý tưởng chính của việc “giả mạo”[37] là tồn tại hai bộ dữ liệu riêng biệt, khi được huấn luyện sẽ tạo ra cùng một tập gradient và (do đó) các mô hình giống nhau . Điều này đúng về mặt trực giác:

- Hãy suy nghĩ về hồi quy tuyến tính, của các điểm trên một đường hoàn hảo; loại bỏ bất kỳ 1 điểm nào cũng không làm thay đổi đường fit;

- Hãy nghĩ đến mini-batch gradient descent, trong đó việc thay thế một gradient bằng tổng của một số gradient “giả” sẽ cho ra cùng một batch gradient.

Việc giả mạo ngụ ý rằng việc làm lãng quên dựa trên DP thực ra có thể không thể kiểm tra được – nghĩa là nhà cung cấp dịch vụ loại bỏ không thể chứng minh một cách hợp thức rằng tập hợp quên thực sự đã bị lãng quên. Trên thực tế, nếu chúng ta chỉ nhìn vào trọng số của mô hình, kể cả việc loại bỏ chính xác cũng có thể không thể kiểm tra được.

Mặc dù người ta có thể coi đây chỉ là các vấn đề mang tính lý thuyết, thực ra các nhà lập pháp nên suy nghĩ cẩn thận về phiên bản tương lai của RTBF (nếu có) sẽ trông như thế nào và liệu các chính sách tương tự có được thực thi về mặt pháp lý và kỹ thuật hay không.

Thật vậy, những gì được coi là “kiểm toán” rất có thể phụ thuộc vào định nghĩa và ứng dụng. Nếu kiểm toán viên chỉ quan tâm rằng mô hình được làm cho quên hoạt động kém trên một tập hợp đầu vào cụ thể (chẳng hạn như trên một tập hợp hình ảnh khuôn mặt), thì ngay cả việc lãng quên theo thực nghiệm cũng “có thể kiểm tra được” (xem phần tiếp theo).

(còn tiếp)

[1] Một số bài viết liên quan như: 1 big thing: AI doesn’t forget, and that’s a problem https://www.axios.com/newsletters/axios-ai-plus-117900d2-3a2c-4741-b807-bb8f2f9bb035.html?chunk=0&utm_term=twsocialshare#story0, The WMDP Benchmark: Measuring and Reducing Malicious Use With Unlearning https://www.safe.ai/blog/wmdp-benchmark, How to Make AI ‘Forget’ All the Private Data It Shouldn’t Have https://hbswk.hbs.edu/item/qa-seth-neel-on-machine-unlearning-and-the-right-to-be-forgotten

[2] Peter Henderson et al (2023) Foundation Models and Fair Use https://arxiv.org/abs/2303.15715

[3] The Times Sues OpenAI and Microsoft Over A.I. Use of Copyrighted Work https://www.nytimes.com/2023/12/27/business/media/new-york-times-open-ai-microsoft-lawsuit.html

[4] https://gdpr.eu/right-to-be-forgotten/

[5] https://unlearning-challenge.github.io/

[6] Patrick Lewis et al (2020) Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks https://arxiv.org/abs/2005.11401

[8] https://en.wikipedia.org/wiki/Foundation_model

[9] Antonio Ginart et al (2019) Making AI Forget You: Data Deletion in Machine Learning, NeurIPS 2019 https://proceedings.neurips.cc/paper/2019/hash/cb79f8fa58b91d3af6c9c991f63962d3-Abstract.html , https://arxiv.org/abs/1912.03817

[10] Chú giải của người dịch: RTBF được phát triển từ một vụ kiện năm 2014 giữa Google Spain v AEPD & Mario Costeja González.

[11] CNBC (2014) Google axes 170,000 ‘right to be forgotten’ links https://www.cnbc.com/2014/10/13/google-removes-170000-right-to-be-forgotten-links.html

[12] Chú giải của người dịch: tác giả đang nhấn mạnh việc mô hình ML là một tập hợp bao gồm cả dữ liệu và sức mạnh điện toán để huấn luyện nó.

[13] https://proceedings.neurips.cc/paper_files/paper/2019/file/cb79f8fa58b91d3af6c9c991f63962d3-Paper.pdf

[14] Yinzhi Cao and Junfeng Yang (2015) Towards Making Systems Forget with Machine Unlearning https://www.ieee-security.org/TC/SP2015/papers-archived/6949a463.pdf, L Bourtoule et al(2019) Machine Unlearning https://arxiv.org/pdf/1912.03817

[15] The Verge (2023) Who owns AI art? https://www.theverge.com/23961021/ai-art-copyright-training-ownership-fair-use

[16] https://support.google.com/youtube/answer/6000976?hl=en

[17] https://platform.openai.com/docs/models/gpt-4-turbo-and-gpt-4

[18] Chú giải của người dịch: Tác giả sử dụng từ non-fungible data, vốn là một cụm từ không phổ biến

[20] Xem khái niệm undue delay: https://gdpr.eu/right-to-be-forgotten/

[21] Eric Mitchell et al (2021) Fast Model Editing at Scale https://arxiv.org/abs/2110.11309

[22] Shashwat Goel et al (2024) Corrective Machine Unlearning https://arxiv.org/abs/2402.14015

[23] The WMDP Benchmark: Measuring and Reducing Malicious Use With Unlearning https://www.wmdp.ai/

[24] Ghi chú của người dịch: Trong xuất bản Differential Privacy Dwork, C., 2006, July. Differential privacy. In International colloquium on automata, languages, and programming (pp. 1-12). Berlin, Heidelberg: Springer Berlin Heidelberg, thuật ngữ quyền riêng tư tách biệt được tác giả dùng để mô tả một khung tính toán qua đó cho phép trích xuất toàn bộ dữ liệu thống kê của một tập dân số trong dữ liệu, mà không làm lộ ra dữ liệu của các cá nhân trng tập dữ liệu đó

[25] Towards Making Systems Forget with Machine Unlearning https://www.ieee-security.org/TC/SP2015/papers-archived/6949a463.pdf , L Bourtoule et al(2019) Machine Unlearning https://arxiv.org/pdf/1912.03817

[26] Anvith Thudi et al (2021) On the Necessity of Auditable Algorithmic Definitions for Machine Unlearning https://arxiv.org/abs/2110.11891

[27] https://en.wikipedia.org/wiki/Neural_scaling_law

[28] Branch-Train-Merge: Embarrassingly Parallel Training of Expert Language Models https://arxiv.org/abs/2208.03306, Model soups: averaging weights of multiple fine-tuned models improves accuracy without increasing inference time https://arxiv.org/abs/2203.05482 , Merge Large Language Models with mergekit https://huggingface.co/blog/mlabonne/merge-models

[29] Martín Abadi et al (2016) Deep Learning with Differential Privacy https://arxiv.org/abs/1607.00133

[30] Ayush Sekhari et al (2021) Remember What You Want to Forget: Algorithms for Machine Unlearning https://arxiv.org/abs/2103.03279

[31] Chú giải của người dịch: tác giả sử dụng thuật ngữ mô hình lồi (convex model) ở đây, tuy nhiên trên thực tế DP-SGD có thể áp dụng cho các các mô hình học sâu (non-convex model)

[32] https://proceedings.mlr.press/v132/neel21a.html

[33] Certified Data Removal from Machine Learning Models https://arxiv.org/abs/1911.03030 , Descent-to-Delete: Gradient-Based Methods for Machine Unlearning https://proceedings.mlr.press/v132/neel21a.html , Adaptive Machine Unlearning https://proceedings.neurips.cc/paper/2021/hash/87f7ee4fdb57bdfd52179947211b7ebb-Abstract.html

[34] Coresets for Data-efficient Training of Machine Learning Models https://arxiv.org/abs/1906.01827

[35] Eugene Bagdasaryan, Vitaly Shmatikov (2019) Differential Privacy Has Disparate Impact on Model Accuracy https://arxiv.org/abs/1905.12101

[36] Xuechen Li et al (2021) Large Language Models Can Be Strong Differentially Private Learners https://arxiv.org/abs/2110.05679

[37] Anvith Thudi et al (2021) On the Necessity of Auditable Algorithmic Definitions for Machine Unlearning https://arxiv.org/abs/2110.11891

[i] Thuật ngữ approximate unlearning cũng có thể được sử dụng để chỉ riêng các định nghĩa tương tự về unlearning thông qua differential privacy (Phần 2.2), vốn đã xuất hiện trong các nghiên cứu trước đây. Ở đây, tác giả đang sử dụng thuật ngữ này theo nghĩa đen của nó nhiều hơn, là hành vi của mô hình unlearned xấp xỉ với (những gì chúng ta nghĩ là) hành vi của mô hình được đào tạo lại.